だいすけ

@daisuke

Followers

2K

Following

20K

Media

3K

Statuses

95K

Still diggin | 消費者|indelible|Flexi Wit Da Tech (nique)|Posts are my own|ヒト, SUMO, 野球, Barca, MSFT MVP-ed, ネタバレ許容 #GoT #BrBa #gihyojp #i18n #Enl #錦木

江古田、市ケ谷、池袋

Joined March 2007

ああ、盛岡場所だったのか。. 玉鷲さんが崇高なんだけど錦木もなにげに休場が少ない徹人さん。. 残念だけど😢.

0

0

1

シガーソケットがクルマのダッシュボードにおけるコモンアイテム、標準化だ(った)。. 時代の変化が急速な界隈でも標準化が浸透するには時間がかかるということだ。. マルチプロバイダーを試せ���any-llmは慌てない。. @MozillaAI.

1

0

0

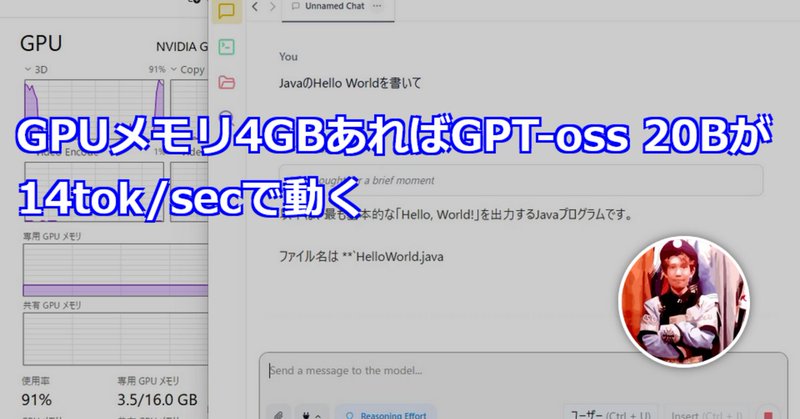

RT @kis: ということで、llama.cppでMoEを効率よくGPU/CPUに振り分ける仕組みを使って、GPT-oss 20BがGPUメモリ4GB使って14tok/secで動くようになったという話。.強いCPU載ってればもっと速いはずだけど、その場合はCPUだけでも速いw….

nowokay.hatenablog.com

llama.cppにMoEに適したCPU/GPUの振り分けのオプションが入って、LM Studioでもそのオプションに対応したことによって、MoEモデルであるGPT-ossが少ないGPUメモリでもそれなりに動くようになりました。 14tok/sec出ています。 CPUだけで動かすと10tok/secだったので、5割マシ…

0

36

0

RT @louis030195: We raised $2.8M to bring AI hands to every Windows desktop. Backed by: @fdotinc., Top Harvest Capital, @seedclubvc, LG Te….

0

10

0

Building AI agents made easy with Goose and Docker | Docker

docker.com

Learn how you can build an AI agent easily with Goose and Docker Model Runner.

0

0

0

simonw/codespaces-llm: Codespaces with LLM pre-configured using GitHub models

github.com

Codespaces with LLM pre-configured using GitHub models - simonw/codespaces-llm

0

0

0