Kyosuke Nishida

@kyoun

Followers

5,293

Following

246

Media

508

Statuses

1,696

NTT人間情報研究所 上席特別研究員.人工知能全般,特に,自然言語処理,Vision-and-Languageに興味があります.大規模言語モデルに関するプロジェクトの統括をしています.

品川

Joined June 2008

Don't wanna be here?

Send us removal request.

Explore trending content on Musk Viewer

Claudia Sheinbaum

• 446131 Tweets

BB X LISA

• 181676 Tweets

増山さん

• 153854 Tweets

増山江威子さん

• 143989 Tweets

ルパン三世

• 109170 Tweets

峰不二子

• 107469 Tweets

#CDTVライブライブ

• 59892 Tweets

NORAWIT and KND

• 48221 Tweets

エミリエ

• 47451 Tweets

TOYOTA GOOD DEAL X MEW

• 32121 Tweets

音楽の日

• 31765 Tweets

不二子ちゃん

• 24812 Tweets

ベンチマーク

• 24174 Tweets

ゲリラ豪雨

• 23486 Tweets

Emilie

• 22784 Tweets

#ISSUE_CONNECT_祝地上波

• 20864 Tweets

Alpine

• 19021 Tweets

しゅごキャラ

• 18853 Tweets

더보이즈

• 18845 Tweets

ピノコニー

• 16962 Tweets

Ocon

• 16055 Tweets

IS:SUE

• 15492 Tweets

God Kabir Prakat Diwas 22June

• 11833 Tweets

Last Seen Profiles

人工知能学会全国大会

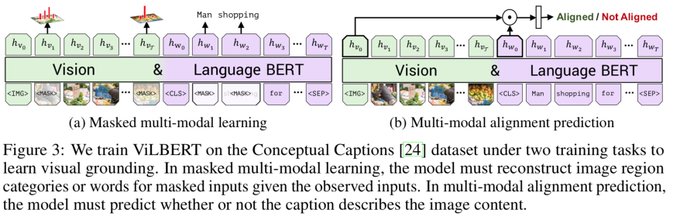

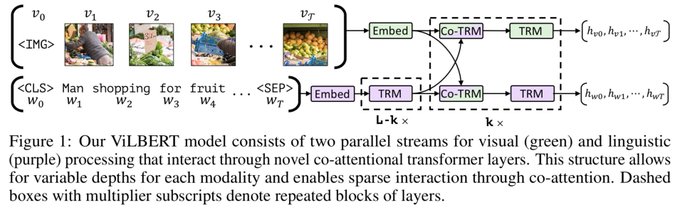

#JSAI2022

チュートリアル講演『自然言語処理とVision-and-Language』の資料をアップロードしました.

本日は現地・オンラインにて多数のご参加ありがとうございました!初めてのハイブリッド形式での講演でしたが議論も盛り上がり楽しかったです!

0

116

529

#xpaperchallenge

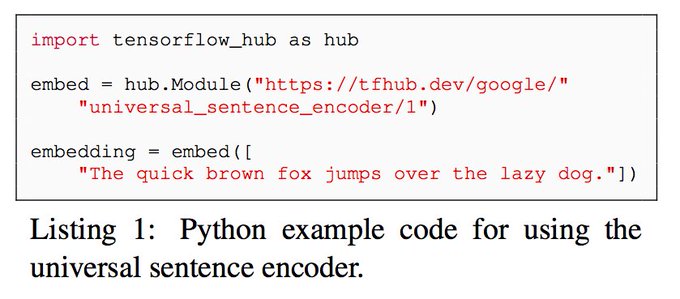

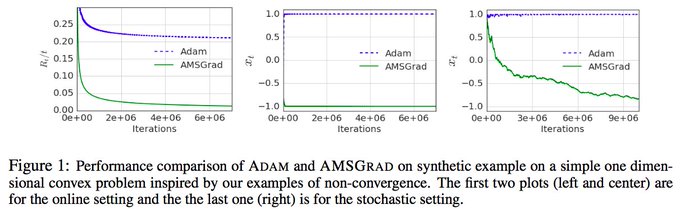

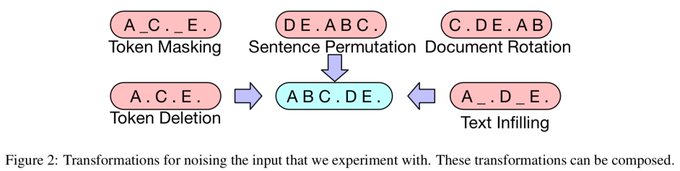

にて講演しました「事前学習言語モデルの動向」について資料をアップロードしました!

ELMo, BERTから最近のALBERT, T5, BARTまで24モデルの概要をまとめました.

0

151

518

#DEIM2023

チュートリアル講演『NLPとVision-and-Languageの基礎・最新動向』(私,

@kosukebs

@rtanaka_lab

,斉藤 )の資料をアップロードしました.

Part1: NLP

Part2: V&L

ChatGPTなど最新動向も含めた渾身の資料となっております!

2

115

420

東北大・鈴木先生

@drJunSuzuki

,東工大・岡崎先生

@chokkanorg

と一緒に国際会議 PAKDD2023 のチュートリアル講演”A Gentle Introduction to Technologies Behind Language Models and Recent Achievement in ChatGPT" を行いました!私は技術動向パートを担当しました.

1

52

202

#LangRobo

研究会にて講演した「Collaborative AI: 視覚・言語・行動の融合」(私,壹岐さん

@ikitaichi

)の資料をアップロードしました.

GPT-4,AutoGPTから始めて「人とAIの協調」に触れ,後半はPC環境で人と協働できる汎用ソフトウェアロボットの動向をまとめました!

0

40

168

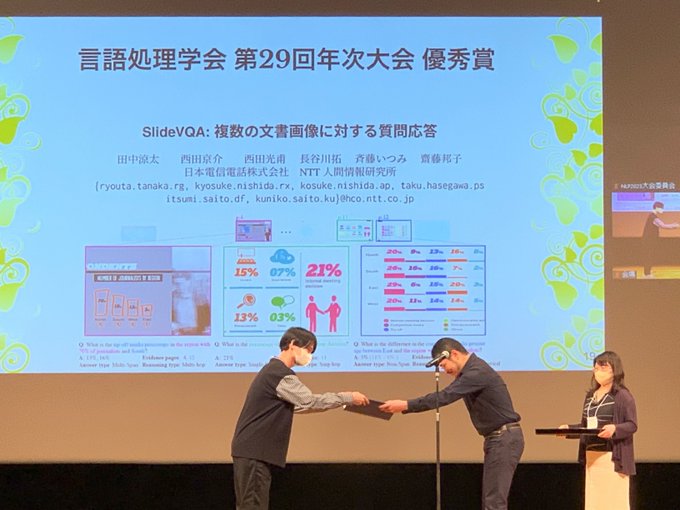

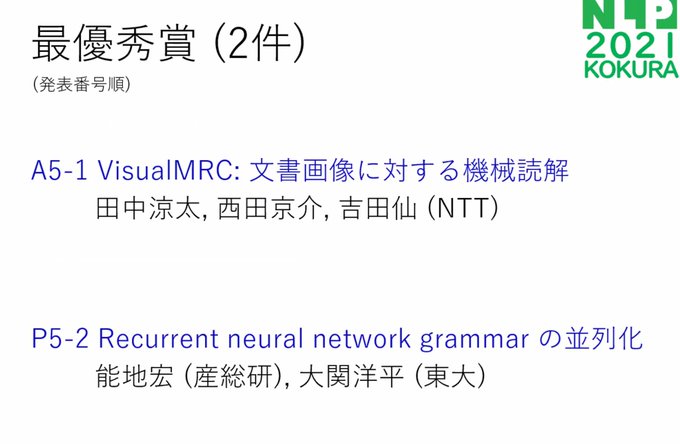

#NLP2021

AI王ワークショップにて「言語と視覚に基づく質問応答の最新動向」について招待講演のスライドをアップロードしました.これまでの Vision-and-language の事前学習とQAや検索への適応と,新たな動きである視覚の中の言語情報の理解の研究動向をまとめたものです!

0

29

129

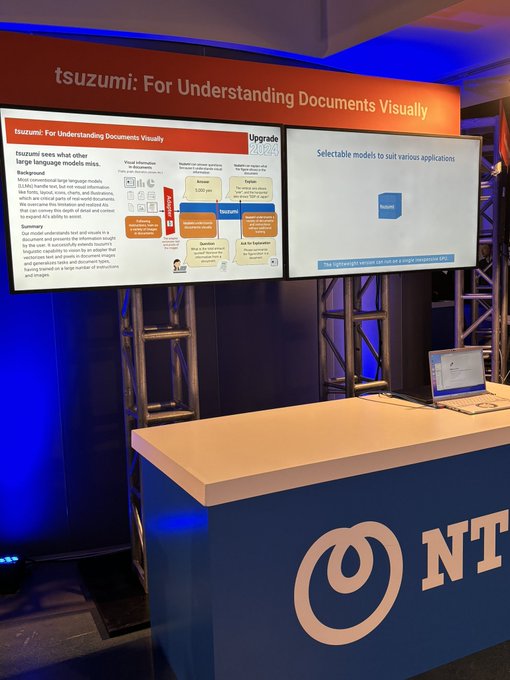

LLMの視覚拡張の研究が AAAI2024に採択されました!田中涼太さん

@rtanaka_lab

2021、2023、2024と主著で連続採択です、素晴らしい!

#AAAI2024

に主著論文「InstructDoc: A Dataset for Zero-shot Generalization of Visual Document Understanding with Instructions」が採択されました!🎉

LLMを活用して、自然言語の指示のみで視覚的に文書を読み解く技術とデータセットの提案です。

2

23

136

0

8

91

11/14〜17、NTT R&D FORUM 2023の特別セッションでNTTのLLM「tsuzumi」に関して講演を行います!11/15は

@SakanaAILabs

の David Ha さん

@hardmaru

、Llion Jonesさん

@YesThisIsLion

との共同セッションです。オンライン配信がありますので、ぜひご参加ください!

1

27

86

AI分野の難関国際会議AAAIにNTTから5件採択

今回,田中涼太(

@rtanaka_lab

)さんの論文が口頭発表で採択されています!私も現地参加予定で,沢山の人とお会いできるのを楽しみにしております!

0

15

75

#AAAI2021

に 田中さん

@rtanaka_lab

との共著 "VisualMRC: Machine Reading Comprehension on Document Images" が 採択されました!文書の「画像」を視覚的に理解して機械読解を行うためのデータセットと技術の提案です.2年間やってきたプロジェクトが遂に形になってきました😃

0

5

64