変化 hEnka

@hEnka_robots

Followers

3K

Following

31K

Media

672

Statuses

7K

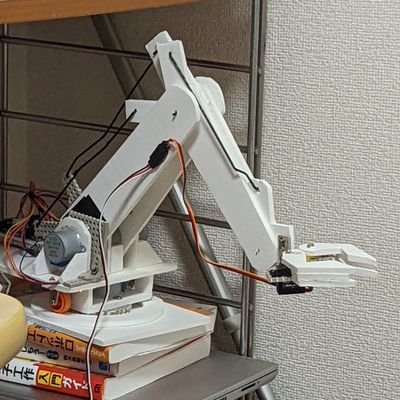

発言は個人の見解に基づくものであり,所属組織を代表するものではありません 自律移動 脚ロボの強化学習 アームの模倣学習 / SLAM&Nav, Reinforcement learning for legged robots, Imitation Learning for robot arms 電気通信大学

東京 / Tokyo

Joined October 2022

卒論を書き終わってひと段落し,修士に向けて新しい研究をしようと思っているが,この際に前の研究でなにができなくて,なにに困っていて,次にやる研究ではこれを解決すると明確に決められるといいと思う.

0

0

1

私の想定は 「学部は教員主導の下、教員から与えられた研究テーマの趣旨を理解し、自身で実行できる」 「修士は学生主導の下、教員と密接に連携し研究テーマを自ら決定し、実行できる」 1人で研究テーマを決定できるのは博士からです。研究テーマの決定は研究で最も難しいです。必ず相談してください。

0

28

195

ERQA(Embodied Reasoning Question Answering)で,2.0Proの優位性はわかったが,4oも十分高くないか?

1

0

0

AIにスライド��ってで解決したら,苦労はしない. AIが作った資料を使って発表するのは自分なのに. 自分じゃなくてAIが発表するならいいけど

0

0

3

🚀Introducing Intern-S1-Pro, an advanced 1T MoE open-source multimodal scientific reasoning model. 1⃣SOTA scientific reasoning, competitive with leading closed-source models across AI4Science tasks. 2⃣Top-tier performance on advanced reasoning benchmarks, strong general

28

140

913

ICLRに投稿されているVLA論文のサーベイ記事を執筆しました。 自身の勉強も含めて、VLAの課題点や流行を把握するためにまとめを作成しました。論文をジャンル別に整理し、モチベーションと提案手法の要点を短くまとめています。 気になるところだけでもぜひ! https://t.co/I4athytumb

zenn.dev

3

46

213

RDT2 paper is here📄 7B VLA trained on 10k+ hours of UMI data Scaling Law: scaling data & model yields predictable gains📈 Zero-shot transfer to new lang, objs, scenes, and even robots🤖3-stage training recipe: beats SOTA baselines on tasks like🏓 https://t.co/eIWPz1aa0P

arxiv.org

Vision-Language-Action (VLA) models hold promise for generalist robotics but currently struggle with data scarcity, architectural inefficiencies, and the inability to generalize across different...

5

15

67

How do you teach a robot to handle complex, multi-step tasks, without training it for each one? [Github ⬇️] The team behind ReKep shows that robots can perform bimanual, in-the-wild tasks by reasoning over keypoint constraints: Generated on the fly using vision and language

4

32

134

Can we bridge the Sim-to-Real gap in complex manipulation without explicit system ID? 🤖 Presenting Contact-Aware Neural Dynamics — a diffusion-based framework that grounds simulation with real-world touch. Implicit Alignment: No tedious parameter tuning. Tactile-Driven:

5

39

268

New milestone: we trained a robot foundation model on a world model backbone, and enabled zero-shot, open-world prompting capability for new verbs, nouns, and environments. If the world model can "dream" the right future in pixels, then the robot can execute well in motors. We

25

93

482

For robots to be actually useful, they need to be reliable. We’re sharing an RL recipe for VLA models that takes a step in this direction, allowing robots to operate autonomously for hours at a time. Blog & paper: https://t.co/SICNEhnXis

26

107

833

最近、バズってるツイートで、あからさまにAIで書きました��ねーってのが増えた気がする。別に悪いとかではないのだが、AI様のありがたい話を聞きにツイッターに来てないので、ミュートしていこうかな

0

0

3