はまなすなぎさ

@RosaRugosaBeach

Followers

2,033

Following

3,721

Media

407

Statuses

12,285

全ての呟きは私個人のささやかな気づきや興味に基づくものです。

Tokyo

Joined September 2016

Don't wanna be here?

Send us removal request.

Explore trending content on Musk Viewer

#KAZZAWARDS2024

• 355580 Tweets

SAROCHA REBECCA IN KAZZ

• 292738 Tweets

スタンプ

• 151968 Tweets

NORAWIT WITH PAUL SMITH

• 68834 Tweets

Varane

• 30958 Tweets

インプレゾンビ

• 28041 Tweets

B1NI TOPS SPOTIFY

• 22061 Tweets

#うたコン

• 13154 Tweets

モグコレ

• 12443 Tweets

#MAZZEL

• 12390 Tweets

名誉毀損

• 11507 Tweets

風の行方

• 10330 Tweets

Last Seen Profiles

SD系手法を用いたアニメ風動画への変換、かつての黎明期の取り組みもすごく感動した記憶がありますが、一貫性が一気に上がってて久しぶりにかなりの衝撃を受けました

ControlNetは納得としてVideo Loop Backてなんだろうと思ったらまた何か出てたっぽい

2

397

1K

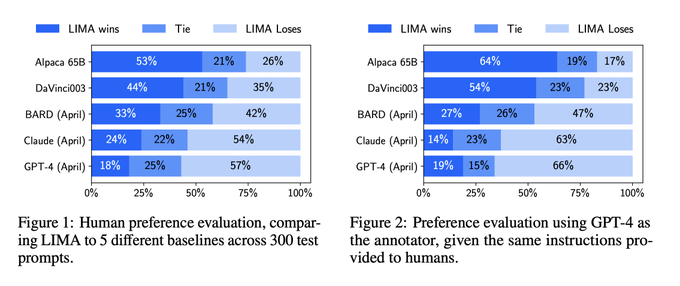

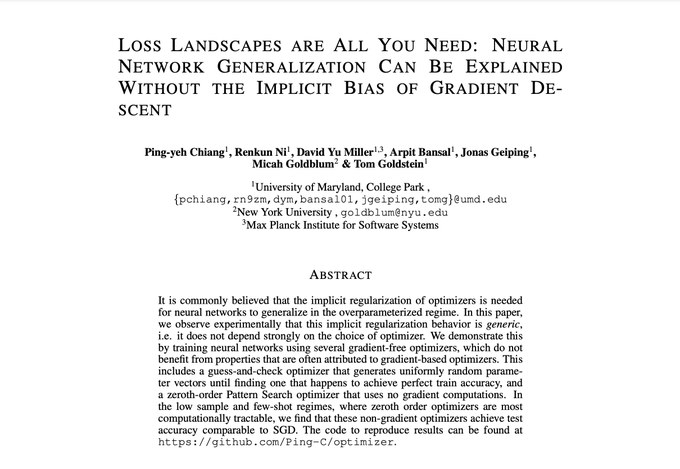

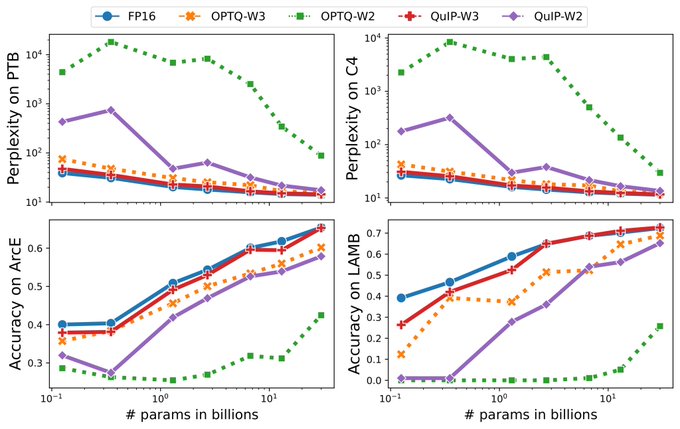

NNsは勾配降下の非明示的な正則化効果で一般化すると思われているが、実は勾配不使用型optimizerでSGDと同程度の汎化性能が得られたのでそんなことないんじゃね?という研究。「平坦な局所極小値」に辿り着くことが大事だとしてパラメータ空間を一様分布から繰り返しサンプリングするだけの手法を提案

It is widely thought that neural networks generalize because of implicit regularization of gradient descent. Today at

#ICLR2023

we show new evidence to the contrary. We train with gradient-free optimizers and observe generalization competitive with SGD.

15

119

683

1

25

166

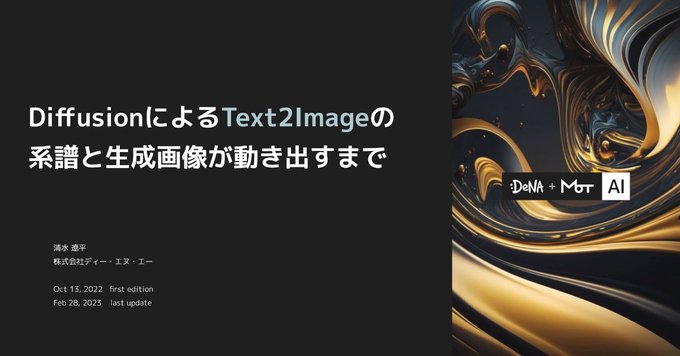

今までのVAE潜在空間経由したtext2videoのチラつきはなんだったんだってぐらい安定していてすごい ピクセルベースで学習するImagenVideoとかに近い滑らかさを感じる

1

26

102

NeRF(の派生手法)に関する解説記事を公開しました。

NeRFそのものの説明は割とあっさりめですが、最近にわかに盛り上がりつつある手法だと思うので、NeRFってどんな技術なのかというところにご興味がある方にも面白い内容になっているのではないかなと思います。よかったら見てみてくださいね。

📣ZENKIGEN技術ブログを更新📣

『NeRF-RPN:NeRF上で物体検出する技術』

NeRF という空間表現の中で構築された初の物体検出手法について解説しました!📸

最近流行りの NeRF 関連手法にも薄く広く触れているので、ご興味のある方はぜひご覧ください。

#NeRF

#物体検出

0

27

98

0

17

79

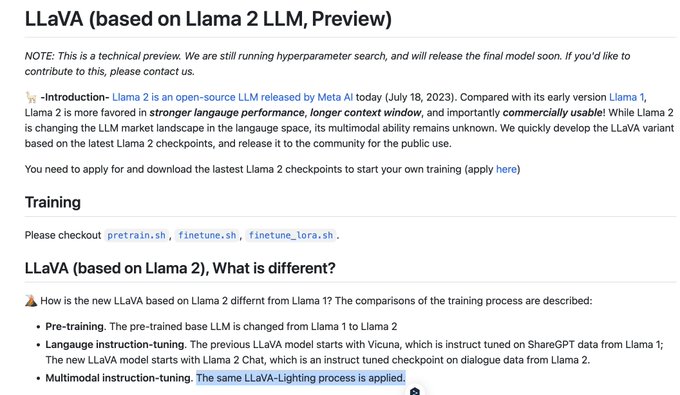

$40あればGPT-4ライクな画像テキストマルチモーダルモデルが3時間程度で学習できるという触れ込みのLLaVA Lightning、そんなうまい話あるか???と思ったがVicuna-7Bから追加学習する前提らしくて納得 それでもかなり効率的な気がする

仕組みを理解すれば他のLLMにも同様の知見を適用できそう

0

12

60

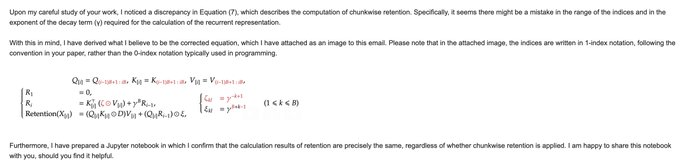

3.5-turbo-16kを調教するために工夫しまくってたスキームをそのまんま4-8kに与えたら「これが欲しかったんだよ……」になった例です

内容はlatexソースから読んでるので数式とかも内容としては反映できてる

(Twitterにあげると文字どれだけ潰れちゃうかわからないけど)

1

5

56

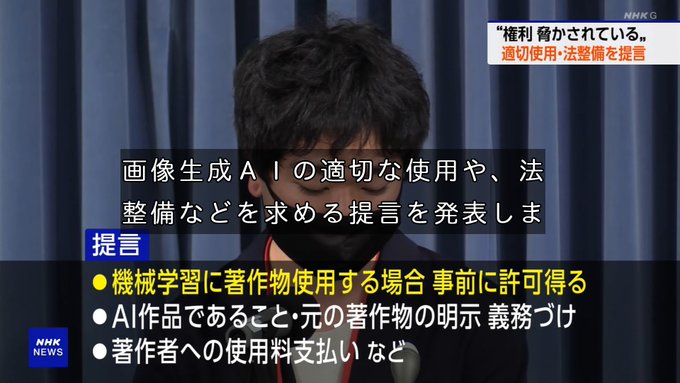

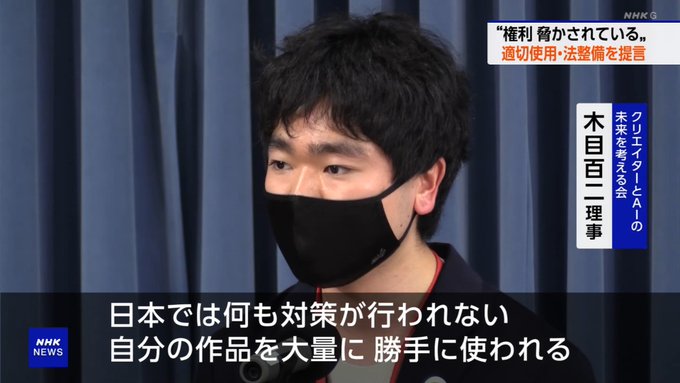

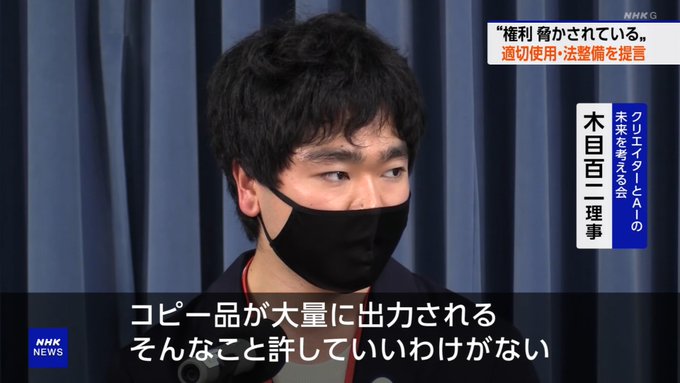

この要求がそのまま実現することはおそらくないと思うけど、こういうことを組織立って主張する人の声が目立ち始めることに、影響力という意味での一定以上の価値があるんだろうなあと感じたりしますね とはいえどういうところに落ち着くんだろうなあこの泥沼の問題

機械学習に著作物を使う場合に許可を取る、というのは今の情報解析を無条件許可してる著作権法と真っ向から衝突するし、政府は AI の方を優先する方針っぽいから分かりあえなさそうだよなぁ この規定を廃止したら実質日本で GPT みたいな LLM は作れなくなるので

#nhk

36

396

883

1

25

48

多視点ビデオを入力とした4K解像度での動的な3次元再構成で、RTX 4090だと80FPSで動いたりするらしい

NeRF系かと思ったら点群処理に基づくようで、その辺追ってないからこんなに綺麗にいくのに驚いた(点群からのレンダリング研究が既に発展してるのか提案手法の貢献かは門外漢なのでこれから読む)

0

11

47